Blogpost

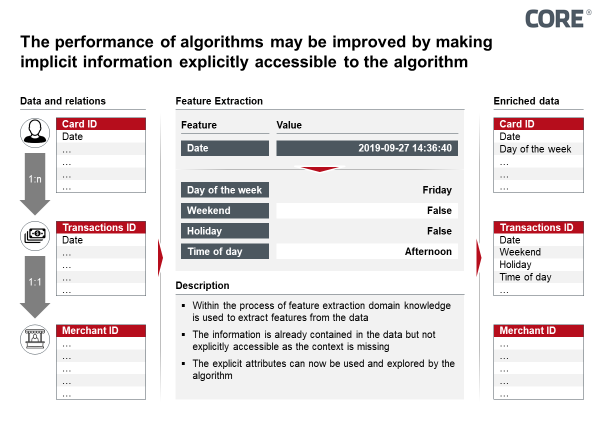

Making it explicit - Prognosefähigkeit von KI-Methoden im Vergleich

Unsere Autoren

Reference items

Expert - Julius Heitmann

Expert Director

Dr. Julius

Heitmann

Dr. Julius Heitmann ist Expert Director bei CORE. Er verwirklichte diverse AI- und Analytics-Projekte im Banken-, Versicherungs- und Medizinsektor. Dabei berät Julius nicht nur unsere Klienten, so...

Mehr lesenDr. Julius Heitmann ist Expert Director bei CORE. Er verwirklichte diverse AI- und Analytics-Projekte im Banken-, Versicherungs- und Medizinsektor. Dabei berät Julius nicht nur unsere Klienten, sondern entwickelt hands-on Software für CORE, die unseren Beratungsalltag effizienter gestaltet. Auf Basis seiner vielseitigen Erfahrungen kann Julius sowohl strategische Perspektiven aufzeigen als auch konkrete Umsetzungen begleiten.

Weniger lesen