Generative AI: Von der Technologie bis zur Umsetzung

GenAI-Leitfaden - jenseits des Hypes

1. Rennaissance des AI-Hypes

Artificial Intelligence (AI, dt. KI für Künstliche Intelligenz) existiert bereits seit Mitte des letzten Jahrhunderts. Doch mit der Einführung der Generative AI (GenAI), symbolisiert durch Tools wie ChatGPT, erlebt sie aktuell nicht nur einen Boom in der breiten Masse, sondern öffnet auch die Tür für Unternehmen, ihre Potenziale im Umgang mit hochdimensionalen Daten wie Bild und Video, um Umsätze zu skalieren und Kosten zu reduzieren.

1.1. Nicht neu, aber anders

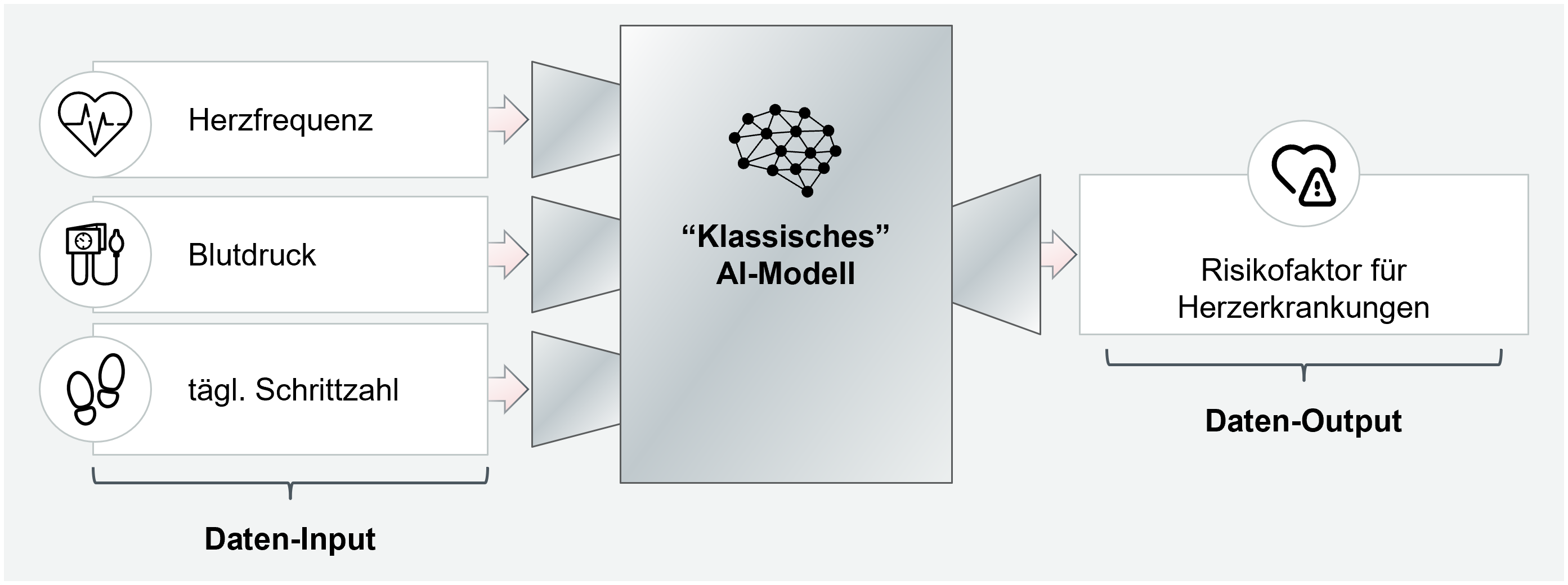

Ein generisches AI-Modell funktioniert im Prinzip wie eine mathematische Funktion: Es erhält einen Input, führt eine Transformation aus und liefert einen Output. So ist beispielsweise ein Modell denkbar, das den Risikofaktor für Herzerkrankungen berechnet (Output), basierend auf drei Eingangsdaten: Herzfrequenz, Blutdruck und durchschnittliche tägliche Schrittzahl (Input).

Abbildung 1: Beispiel für ein klassisches, nicht generatives KI-Model, welches über Machine-Learning realisiert werden kann

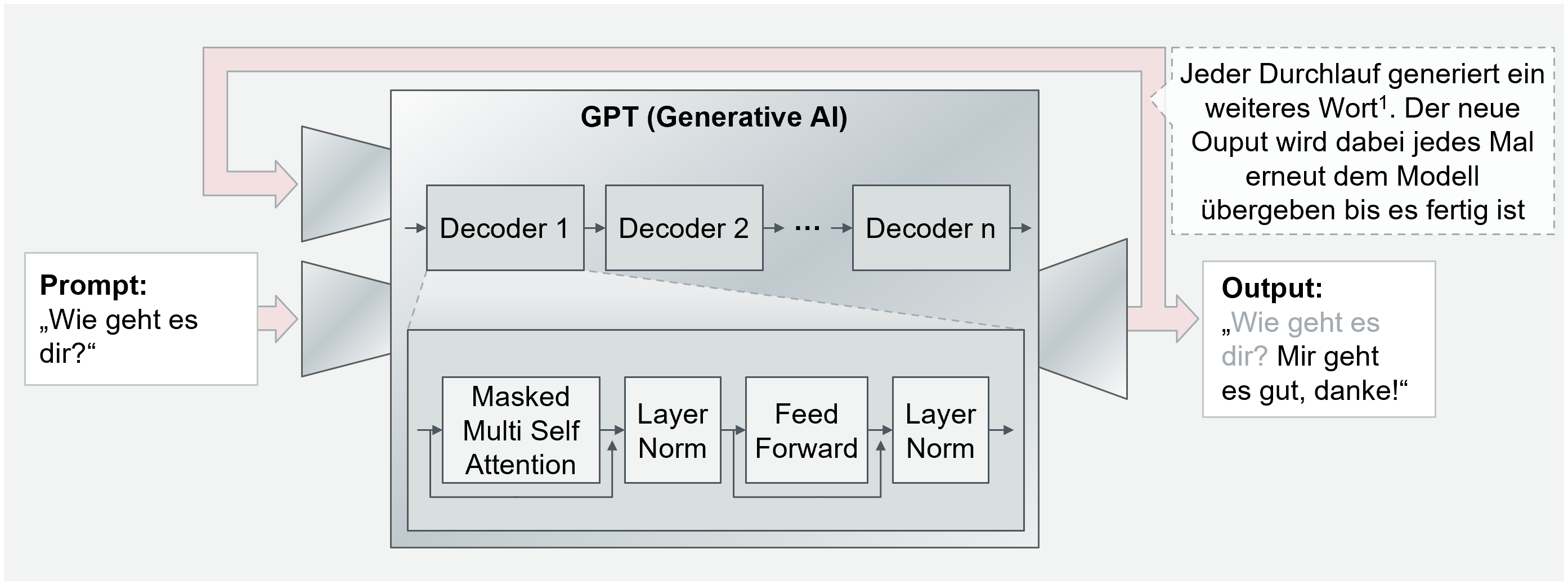

Generative AI, die mittels umfangreicher Datensätze (Input) und einer komplexen Architektur (Transformation) trainiert wird, hat die Fähigkeit, als Output überzeugend menschenähnliche digitale Inhalte zu erstellen. Diese Inhalte sind oft strukturell und inhaltlich innovativ: GPT-4 von OpenAI beispielsweise nimmt Texteingaben entgegen und produziert Texte mit menschlichen Sprachmustern und Semantik. GenAI kann Outputs in Form von Text, Bild oder Ton erzeugen sowie Kombinationen dessen, in Form von Videos und vertonten Texten abbilden. Die Textgenerierung wird von sogenannten Large Language Models (LLM), wie GPT (Generative Pre-trained Transformer von Open AI), LLaMA (Large Language Model Meta AI von Meta) oder PaLM (Pathway Language Model von Google), abgedeckt. Diese LLMs können sowohl natürliche Sprache als auch formale Sprache, beispielsweise Programmiersprachen, eigenständig generieren. Sie haben gemein, dass sie durch ihre komplexe Struktur und das Training mit großen Mengen an Textdaten, tiefes Verständnis von Sprache und Inhalten erlangen. Dabei ist zu differenzieren, dass diese Modelle Konzepte eher nachahmen und trainierte Muster rekombinieren als Sinnzusammenhänge wirklich zu "verstehen".

Abbildung 2: Funktionsweise und Aufbau eines Generative AI-Modells am vereinfachten Beispiel der GPT-LLMs1 mit Originalbezeichnungen der technischen Komponenten.

1.2. Marktdynamik nimmt zu

Der Begriff der AI wurde bereits in den 1950er Jahren geprägt. In den letzten Jahrzehnten haben kontinuierliche Entwicklungen in AI-Technologien, insbesondere die Machine-Learning- und Deep-Learning-Revolution, zu effizienteren Trainingszeiten und komplexeren Netzmodellen geführt. Die Erstellung heutiger Large Language Models wurde ermöglicht durch die Einführung der Transformer-Architektur, einer speziellen Form des Deep Learnings, diemöglich gemacht wurde durch den sogenannten Self-Attention-Mechanismus.Dieser erkennt über ein dessen dem Netz Zusammenhänge in Wortfolgen. Populäre Anwendungen wie ChatGPT von OpenAI entstanden auf Basis dieser Technolgie und eröffneten neue Möglichkeiten für AI-Anwendung in unterschiedlichen Bereichen.

Der Hype um ChatGPT könnte den Eindruck erwecken, dass es die einzige GenAI-Technologie ist, jedoch ist dies nicht der Fall: Der Markt bietet eine Vielzahl von Anbietern und Produkten im Bereich Generative AI, die in verschiedenen Anwendungen wie Textgenerierung, Bildsynthese und Sprachverarbeitung integriert sind. OpenAI, mit der GPT- und der DALL-E Reihe, ist einer der Hauptakteure. Google, Microsoft und Amazon Web Services (AWS) bieten ebenfalls umfassende Produkte und Dienste für Generative AI. Die Landschaft dieser Technologie entwickelt sich ständig weiter und umfasst mehrere Anbieter und Produkte. Ebenso nimmt die Integration dieser Technologie in verschiedenen Anwendungen zu. Die GPTs Plattform von Open AI ermöglicht es Anwendern, über GPT als Sprachinterface, GPT-getriebene Anwendungen zu definieren und somit nicht nur einzelne Probleme, sondern ganze Problemgruppen strukturell zu lösen. Nutze man also in der Vergangenheit ChatGPT manuell um mit einer Reihe von Fragen Zahlen, Daten und Fakten aus Geschäftsberichten zu extrahieren, kann jetzt per Sprachinterface ein Programm definiert werden, das diesen Workflow für einen Geschäftsbericht automatisch ausführt. Diese benutzerfreundliche und der breiten Öffentlichkeit zugänglichen Herangehensweise war bereits mit ChatGPT der Schlüssel für den Erfolg von Open AI. Es ist zu vermuten, dass GPTs zu einem weiteren Höhenflug von Open AI führen könnte. Perspektivisch wird es sich mit den LLMs ähnlich verhalten wie mit anderen Machine Learning Modellen: Ab einem bestimmten Reifegrad werden ältere Modelle open-source für die Öffentlichkeit zugänglich. Die Qualität der neuen Modelle unterscheidet sich mit der Zeit nicht mehr signifikant von den open-source Modellen. Somit werden dann weniger die Modelle selbst, sondern die Frameworks den Unterschied in der Anwendung machen (z.B. Google Tensorflow oder Meta PyTorch).

2. Aus dem unerschöpflichen Spektrum potentieller Use Cases die Richtigen wählen

AI birgt das Potenzial, Branchen zu revolutionieren. Nicht umsonst wird von „disriptive technologies“ gesprochen. In einem innovationsgetriebenen Markt, geprägt von hohem Wettbewerbsdruck, können AI-gestützte Use Cases zu genau solchen disruptiven Veränderungen führen. Während es verlockend sein mag, von standardisierten Anwendungsfällen auszugehen, zeigt die Realität, dass eine Einzelfallbetrachtung geboten ist. Zwar gibt es wiederkehrende Anwendungsfälle - die 24/7-Kundensupport-Hotline, intuitive Dashboards, die tief in Daten eintauchen und innovative Bildgenerierung für Marketingzwecke - doch liegt der Schlüssel darin, mögliche Use Cases für das eigene Unternehmen sorgfältig zu prüfen und sich nicht auf starre Modelle zu verlassen.

2.1. Use Case Potenziale erkennen

Die Adaption der Technolgie erfordert zunächst eine sorgfältige Use Case-Analyse.

Grundsätzlich ergeben sich potenzielle Use Cases aus Datentypen und Zielen. In einem ersten Schritt werden die Ziele definiert. Zu den Anwendungszielen zählen:

- Generierung von Datenpunkten: Erstellung neuer Objekte, z.B. durch Vorschläge im kreativen Prozess oder die Produktion von auf Likes optimierten Social Media Posts. Das Objekt kann dabei mit einem einzigen Prompt (die Eingabe einer Anfrage an ein GenAI-Modell) oder in einem iterativen Prozess in einer Serie von Prompts erstellt werden, sodass Zeitaufwand verringert und der kreative Prozess erweitert werden kann.

- Interaktion mit dem Modell: Nutzung der Modelle als Gesprächspartner, wie z.B. Chatbots, die mit anderen GenAI-Modellen interagieren. LLM Modelle können dabei alle Muster und damit Inhalte, die im Trainingsdatensatz enthalten waren, in die Konversation einbringen. Dies hebt sie von bisherigen Retrieval-basierten Chatbots wie Alexa ab, die nur vorgegebene Antworten zurückgeben konnten.

- Erschließen von Informationen: Spezialfall der Interaktion, bei dem Informationen für Training oder Kontext genutzt werden, z.B. Recherche in Dokumenten oder Bildgenerierung für Kampagnen. Das Modell wird dabei als Interface zum Dokument oder Bild genutzt. Es können Anfragen zu Inhalten gestellt werden, sodass auch große Mengen an Informationen mit geringem Zeitaufwand konsumiert werden können.

2.2. Machbarkeit bestimmen

Sind die Ziele des Use Cases festgelegt, gilt es, die Machbarkeit aus verschiedenen Perspektiven zu bestimmen:

- Determinismus: Stellt man einem GenAI-Modell zweimal die gleiche Frage, kann sie zwei verschiedene Antworten geben. Die Modelle sind nicht deterministisch, was bei manchen Use Cases ungewollt ist (z.B. der Use Case: Kreditkarte sperren). Der Einsatz von gezielten Prompting-Methoden verringert dieses Problem. Je mehr Kontrolle gewünscht wird, desto schwieriger gestaltet sich allerdings die Nutzung.

- Pretrained Models: Es muss geprüft werden, ob passende vortrainierte Modelle verfügbar sind. Sollte kein Modell verfügbar sein, erhöht sich der Trainingsaufwand drastisch.

- Datengrundlage: Obwohl viele GenAI-Modelle stark generalisierend sind, also für ähnliche Anwendungen verwendet werden können, ist manchmal ein Finetuning oder komplettes Training erforderlich. Eine entsprechende Datengrundlage ist daher zu schaffen.

- Rechenleistung: Die Anwendung großer Modelle erfordert oft spezialisierte Hardware und Rechenzentren - typischerweise GPUs/TPUs. Während bei Server-basierten Anwendungen oder mit geeigneter lokaler Hardware solche Modelle problemlos betrieben werden können, ist beispielsweise die lokale Anwendung auf mobilen Endgeräten recht schwer zu realisieren. Je nach Lastspitzen der avisierten Anwendung wird es hoher Wahrscheinlichkeit sinnvoll sein Cloud-Umgebungen zu wählen.

- Compliance: Regulatorische Bedingungen (z.B. DSGVO) können die Datenverarbeitung stark einschränken. GenAI-Modelle können web-basiert sein und eingige von ihnen lernen weiter aus den Prompts der Nutzer. Sind die Informationen dann erlernt, können sie von anderen Nutzern durch Prompts abgefragt werden und sind gleichzeitig so komplex gespeichert, dass sie nicht gezielt verlernt, bzw. aus dem Modell gelöscht werden können. Es ist anzuraten jeden Use Case durch einen technologiegeschulten Compliance Mitarbeiter:in zu validieren.

Nach der Zielsetzung und Machbarkeit, konzentriert sich die Analyse auf die wirtschaftliche Rentabilität. Im Business Case müssen sowohl direkte als auch indirekte Kosten, einschließlich Schulung, Systemanpassung und Modellweiterentwicklung und -betrieb berücksichtigt werden. Erfüllt das Modell einen Zweck und kann als machbar und rentabel eingestuft werden, so ist ein wirtschaftlicher Use Case identifiziert.

3. Herausforderungen in der Operationalisierung von GenAI im Unternehmen

Die Einführung von GenAI in einem Unternehmen ist mehr als nur eine technische Herausforderung; sie verlangt ebenso tiefgreifende organisatorische Adaptionen und eine umfassende rechtliche Betrachtung.

3.1. Rechtlich

Die rechtlichen Herausforderungen von GenAI sind vielfältig und unterscheiden sich von Rechtsordnung zu Rechtsordnung. Neben dem nun zur Einigung gefundenen EU AI Act und der sich im Abstimmungsprozess befindlichen EU KI-Haftungsrichtlinie, beeinflussen bereits existierende nationale Regelungen, insbesondere im Bereich des Urheber- und Datenschutzrechts, den Umgang mit GenAI. Im Anwendungsbereich des deutschen Rechts ergeben sich daher entlang der Verarbeitungskette weitreichende Herausforderungen.

- Beim Input spielen der Datenschutz und das Urheberrecht eine zentrale Rolle, in Form der Eingabe von personenbezogenen Daten und der Verwendung von urheberrechtlich geschützten Werken im Prompt. Im Unternehmenskontext besteht zudem die potenzielle Gefahr des Verlustes des Schutzes von Geschäftsgeheimnissen, aufgrund fehlender Schutzmaßnahmen, wenn diese durch Mitarbeiter im Prompt verwendet werden.

- Während der Verarbeitung stellt sich zunächst die generelle Frage der Zulässigkeit nach sektorspezifischen Vorgaben. Darüber hinaus sind eventuelle Mitbestimmungsrechte des Betriebsrates bei der Verwendung von GenAI zu beachten. Zudem können Fragen der Produktsicherheit und Haftung auftreten. Denn auch bereits heute kann eine fehlgeleitete AI haftungsrechtliche Ansprüche nach den allgemeinen zivilrechtlichen Anspruchsgrundlagen auslösen.

- Bezüglich des Outputs, liegt die größte Herausforderung wieder im Bereich des Urheberrechts, da in Ermangelung einer persönlichen geistigen Schöpfung durch eine AI kein Urheberrecht entsteht. Dies führt unweigerlich dazu, dass keine Lizenzen an AI generierten Werken eingeräumt werden können. Werke der AI sind grundsätzlich gemeinfrei. Daneben gilt es weitere Stolperfallen zu vermeiden, wie bspw. das Kartellrecht in Fällen der koordinierten automatisierten Preissetzung oder dem Arbeitsrecht, welches zu einer persönlichen Leistungserbringung verpflichtet.

Mit Spannung erwartet wird neben den bereits bestehenden nationalen Vorschriften die EU KI-Haftungsrichtlinie, die die Zuordnung unrechtmäßigen Handelns bei verschuldensabhängigen Haftungsansprüchen in Bezug auf die „Black-Box“-AI lösen soll. Daneben gilt ein Hauptaugenmerk dem nun zur Einigung gefunden EU AI Act, welcher mit Veröffentlichung im Sommer 2024 in Kraft treten wird und eine zweijährige Umsetzungsfrist vorsieht. Der EU AI Act verfolgt dabei einen risikobasierten Ansatz, ermöglicht präventive Risikoabschätzungen und schreibt je nach Gefährdungspotenzial unterschiedliche Schutz- und Sicherheitsmaßnahmen für KI-Systeme vor.

Es bleibt abzuwarten, wie sich bereits im Gesetzgebungsprozess befindliche Normen entwickeln und sich das nationale Recht auf die neuen Herausforderungen einrichten wird. Den Adressaten dieser Normen, insbesondere im geschäftlichen Kontext ist daher zu raten, sich frühzeitig neben der technischen Dimension auch um ein umfassendes Compliance-System zu kümmern, um das ganze Potenzial von GenAI rechtssicher nutzen zu können.

3.2. Technisch

Auch in technischen Bereichen lassen sich Herausforderung im Einsatz von GenAI beobachten:

- Eine Kernherausforderung im technischen Bereich ist die Datenverfügbarkeit. Der effiziente Betrieb von AI hängt von der Qualität und Quantität der Daten ab. Neben technischem Wissen sind Datenschutz und Ethik entscheidend. Datenherausforderungen beinhalten Datenverzerrung und Sicherheit. Das Erstellen robuster Daten-Pipelines und Governance-Frameworks ist daher essenziell.

- Bei der Gestaltung des AI-Setups im Unternehmen ist die Wahl des richtigen Modells zentral. Dieses bestimmt die Systementscheidungen und hängt von Problemart, Datenqualität, Rechenkapazität und Anwendungsziel ab. Die Modellarchitektur und -optimierung beeinflussen die Performance. Ein ständiges Anpassen und Ausbalancieren von Genauigkeit, Fairness und Interpretierbarkeit ist nötig.

- Die dritte Herausforderung ist die Integration in bestehende IT-Strukturen. Viele Organisationen besitzen Legacy-Systeme, die nicht AI-orientiert sind. Die Einbindung von AI in solche Systeme erfordert Planung und Expertise. Ein reibungsloser Datenfluss, Konnektivität und Kompatibilität sind essenziell.

Um AI erfolgreich zu nutzen, ohne die Betriebsstabilität zu gefährden, müssen diese vielschichtigen Herausforderungen gemeistert werden. Voraussetzung dafür bildet im ersten Schritt die technische Basis, die bereits im Unternehmen vorliegt. Eventuell müssen technische Anstrengungen unternommen werden bevor weitreichendere AI-Zielsetzungen verfolgt werden können. Eine entsprechende Analyse wird angeraten um nicht mitten im Prozess eine ernüchternde Realisierung zu erleben. Wie große Sprünge auf der vorliegenden technologischen Basis gewagt werden können ist wiederum von den vorliegenden Kompetenzen und Erfahrungswerten im Unternehmen abhängig. Auch hier wird zu einer vorgelagerten Analyse angeraten, um Kompetenzlücken nicht im Nachhinein feststellen zu müssen.

3.3. Organisatorisch

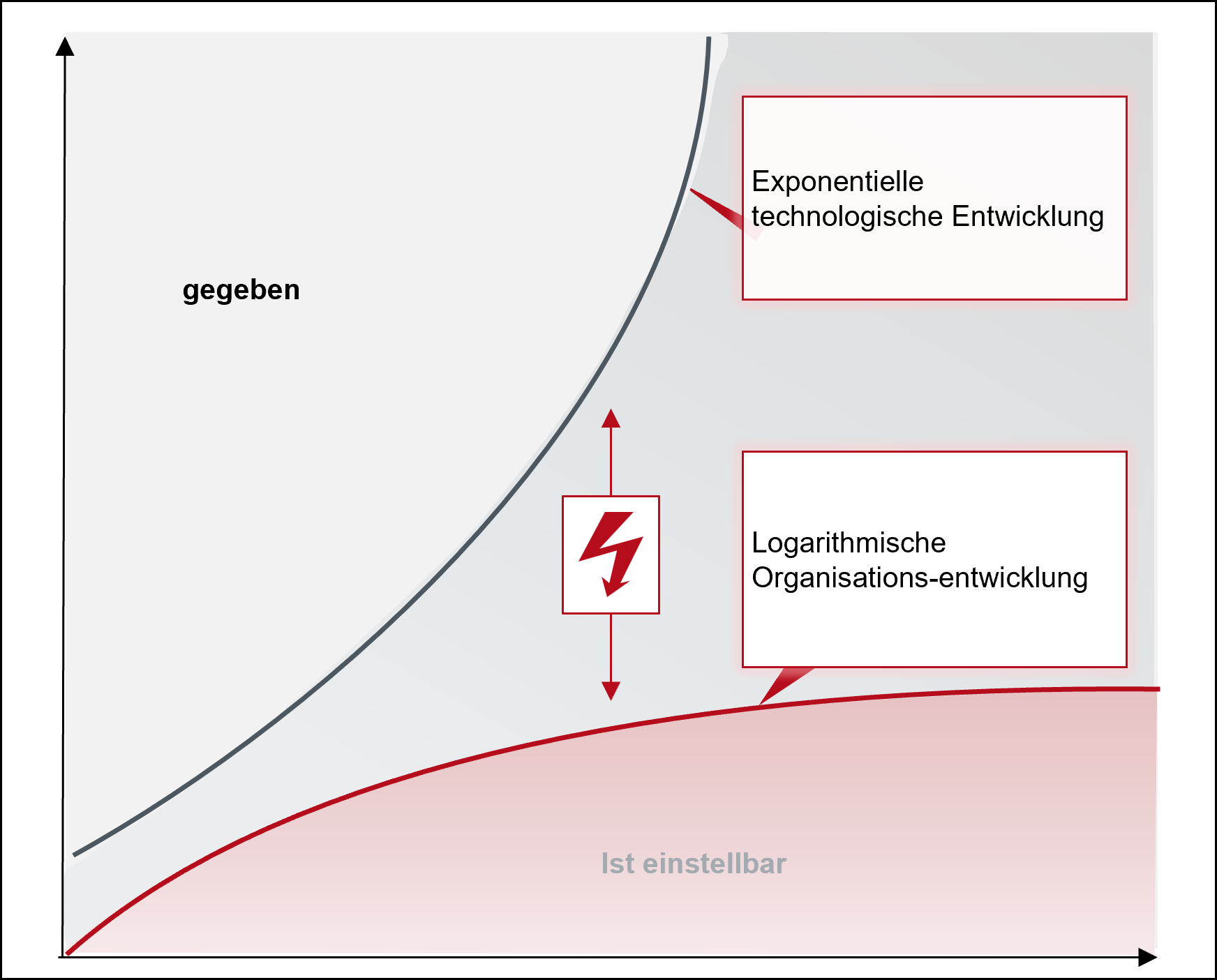

Während die Technologie rasant voranschreitet, sind Organisationen oft nicht in der Lage, ihre Strukturen, Strategien und Belegschaft schnell genug anzupassen, um das volle Potenzial neuer Innovationen zu nutzen. "Martec's Gesetz" visualisiert die wachsende Kluft zwischen der rasanten Entwicklung von Technologie im Vergleich zur langsameren Organisationsentwicklung, welche dazu führt, dass Organisationen die technologischen Möglichkeiten kaum annehmen und integrieren können.

Abbildung 4: Visualisierung von Martec's Law

Die Bereitschaft der Organisation ist eine Grundlage für die Nutzung von AI-Technologien. Allerdings gibt es Hindernisse bei der Organisationsentwicklung im Kontext von AI:

- Das Hauptproblem ist oft eine lückenhafte Data Governance, was rechtliche, ethische und Datenschutz-Probleme auslösen kann. Solche Vorfälle können rufschädigend wirken.

- Es fehlt häufig an AI-Verständnis. Unzureichendes Wissen und blindes Vertrauen in AI führen zu Fehlinterpretationen und verpassten Chancen.

- Organisationsinterner Widerstand gegen AI hemmt dessen Implementierung und senkt den Mehrwert.

Um die Diskrepanz zwischen technologischem Fortschritt und Organisationsentwicklung zu überbrücken, ist eine datenorientierte Kultur entscheidend. Es sei daran erinnert, dass zur Automatisierung einer Tätigkeit durch Einsatz von AI-Methoden das Wissen um die Fachlichkeit und somit die Fachkraft selbst benötigt wird, die schlussendlich durch die AI-Komponente unterstützt oder ersetzt werden soll. Ein fehlendes Verständnis oder ein bedrohter Arbeitsplatz senken die Bereitschaft zu dieser Unterstützung. Die Definition passender Projektstrukturen zusammen mit gleichzeitiger Aufklärung, Kommunikation und Schaffung entsprechender Anreizstrukturen können den Unterschied für den Projekterfolg ausmachen.

4. Checkliste auf dem Web zu Generative AI

Die Relevanz von GenAI für Unternehmen wird immer deutlicher. Wenn Unternehmen nicht gegenüber ihren Konkurrenten ins Hintertreffen geraten und ihr volles Potenzial nutzen möchten, stellt sich die Frage nach den nächsten strategischen Schritten. Anstatt voreilig Insellösungen zu implementieren, deren Aufwand ihren Nutzen oft übersteigen, sollten das Management einen kohärenten, ganzheitlichen Ansatz verfolgen. Ein solcher kann in fünf essenzielle Schritte unterteilt werden:

Strategisch ausrichten: Formulieren einer klaren Position auf Management- und Unternehmensebene zu GenAI. Konkret bedeutet dies, dass Ansichten und Strategien in Bezug auf AI und GenAI definiert werden. AI und GenAI sollten Bestandteil der Geschäfts- oder IT-Strategie sein. Eventuell ist es sinnvoll für das Unternehmen, eine eigene AI-Strategie zu entwickeln oder bestehende Strategien zu erweitern.

- Datengrundlagen schaffen: AI benötigt strukturierte Trainingsdaten aus dem Unternehmen. Ist die Datenlandschaft bereit für das AI-Zeitalter? Daten sollten zugänglich, normalisiert und integrierbar sein und darüber hinaus sollten die rechtlichen Rahmenbedingungen für die Nutzung geklärt sein. Die Datenlandschaft ist demnach bezüglich GenAI-Tauglichkeit zu evaluieren und entsprechend zu modernisieren.

- Entwicklungsgrundlagen schaffen: GenAI-Lösungen können On-Prem2 entwickelt oder fertig einkauft werden. Eigenentwickelte On-Prem Lösungen sind interessant, da sie Flexibilität bieten und Kosten sparen können. Gleichzeitig müssen besondere Entwicklerkompetenzen und technische Infrastrukturen als Grundlagen geschaffen werden. Dabei können moderne Plattformen wie EPAMs AI DIAL helfen den Spagat zwischen On-Prem und Marktlösungen zu schlagen und Implementierung zu beschleunigen.

- Kultur schaffen: Mitarbeiter müssen GenAI adaptieren und sich perspektivisch neuer AI-unterstützen Prozesse und Umgang mit der Technologie weiterbilden. Damit es in die Unternehmenskultur einfließen kann, müssen Adaptionsanreize geschaffen und die Angst vor dem durch GenAI ersetzt werden genommen werden. Dann können Mitarbeiter ihren Umgang und ihr Wissen ausbauen und GenAI-Dienstleistern auf Augenhöhe begegnen.

- Use Case selektieren und Proofs of Concept (PoC) entwickeln: Es gibt zahlreiche potenzielle Use Cases für Ihr Unternehmen. Es ist wichtig, viele mögliche Use Cases zu identifizieren und zu bewerten. Ein fundiertes Verständnis der technischen Möglichkeiten und der Implementierung von GenAI ist für die Entwicklung und Bewertung von Use Cases unerlässlich. Nachdem eine engere Auswahl oder ein spezifischer Use Case getroffen wurde, müssen zur finalen Validierung PoC erstellt werden.

In der Praxis zeigt sich, dass opportunitätsgetriebene Gen-AI Projekte ohne die beschriebene Grundlage oft nicht den gewünschten Mehrwert bringen oder gar in der praktischen Umsetzung scheitern. Umgekehrt kann schon ein kurzes Strategieprojekt auf entsprechender Entscheidungsebene helfen, die technologischen Potenziale dieser Technologie holistisch in der

Unternehmensstrategie zu verankern und damit zur nachhaltigen Wettbewerbsfähigkeit beitragen. Manager sind daher angehalten, die notwendige Expertise für die interne Diskussion bereitzustellen.